NVIDIAが推論AIを低コスト・高効率で稼働するための高速化ライブラリ「NVIDIA Dynamo」を公開、DeepSeek-R1を30倍に高速化可能とアピール

半導体大手のNVIDIAがOpenAI o1やDeepSeek-R1といった推論AIを高速化するためのライブラリ「NVIDIA Dynamo」を公開しました。NVIDIA Dynamoはコストを削減しつつ推論パフォーマンスを向上させることが可能で、DeepSeek-R1のスループットが30倍に向上したとNVIDIAはアピールしています。

Scale and Serve Generative AI | NVIDIA Dynamo

https://www.nvidia.com/en-us/ai/dynamo/

NVIDIA Dynamo Open-Source Library Accelerates and Scales AI Reasoning Models | NVIDIA Newsroom

https://nvidianews.nvidia.com/news/nvidia-dynamo-open-source-library-accelerates-and-scales-ai-reasoning-models?linkId=100000349576608

推論AIはプロンプトごとに「推論」するために数万のトークンを生成します。推論コストを継続的に下げながら推論パフォーマンスを向上させることで、成長が加速し、サービスプロバイダーの収益機会が増加します。

NVIDIA DynamoはNVIDIA Triton Inference Serverの後継で、「推論AIを導入するAIファクトリーのトークン収益生成を最大化するよう設計された新しいAI推論サービングソフトウェア」とNVIDIAは表現しました。

NVIDIA Dynamoは数千のGPU間で推論通信を調整および高速化し、分散サービングを使用して、大規模言語モデル(LLM)の処理フェーズと生成フェーズを異なるGPUに分離します。これにより、各フェーズを特定のニーズに合わせて個別に最適化し、GPUリソースを最大限に活用できるようになるとのこと。

NVIDIA Dynamoは同じ数のGPUを使用することで、NVIDIA HopperプラットフォームでLlamaモデルを提供するAIファクトリーのパフォーマンスおよび収益を2倍に増加させることが可能。GB200 NVL72ラックの大規模クラスターでDeepSeek-R1モデルを実行する場合、NVIDIA Dynamoのインテリジェントな推論最適化により、生成されるトークンの数をGPUごとに30倍以上に増加させることができます。

こうした推論パフォーマンスの向上を実現するために、NVIDIA Dynamoにはスループットの向上とコスト削減を可能にする機能が組み込まれています。変動するリクエストの量と種類に応じ、GPUを動的に追加・削除・再割り当てできるほか、大規模なクラスター内の特定のGPUを特定し、応答計算を最小限に抑え、クエリをルーティングすることも可能。また、推論データをより手頃なメモリやストレージデバイスにオフロードし、必要に応じて素早く取得することで、推論コストを最小限に抑えることができるそうです。

推論パフォーマンスを向上させるため、NVIDIA Dynamoはリクエストの処理から推論システムがメモリに保持する「KVキャッシュ」を数千のGPUにマッピングします。次に、新しい推論要求を最もよく一致する「KVキャッシュ」を持つGPUにルーティングすることで、コストのかかる再計算を回避し、GPUを解放して新しい受信要求に応答できるよう設計されています。

これについてPerplexity AIの最高技術責任者であるデニス・ヤラッツ氏は、「毎月何億ものリクエストを処理するために、Perplexity AIはNVIDIA製GPUと推論ソフトウェアを利用して、ビジネスとユーザーが求めるパフォーマンス、信頼性、拡張性を実現しています」「強化された分散サービス機能を備えたNVIDIA Dynamoを活用することで、推論サービスの効率をさらに高め、新しいAI推論モデルのコンピューティング需要に対応していきたいと考えています」と語りました。

さらに、NVIDIA Dynamoの推論プラットフォームは分散型サービスもサポートしており、ユーザークエリの理解構築および最適な応答の生成を含むLLMのさまざまな計算フェーズを、異なるGPUに割り当てることが可能。このアプローチは高度な推論手法を使用してコンテキストの理解と応答生成を向上させる新しいNVIDIA Llama Nemotronモデルファミリーなどの推論モデルに最適だそうです。分散型サービスにより、各フェーズを個別に微調整してリソースを割り当てることができるため、スループットが向上し、ユーザーへの応答が速くなります。

AIアクセラレーションクラウドであるTogether AIは、独自のTogether推論エンジンをNVIDIA Dynamoと統合し、GPUノード間で推論ワークロードをシームレスにスケーリングできるようにしたいと考えています。これにより、Together AIはモデルパイプラインのさまざまな段階でトラフィックのボトルネックを動的に解決することが可能となるそうです。

Together AIの最高技術責任者であるチェ・チャン氏は、「推論モデルをコスト効率よく拡張するには、分散型サービスやコンテキスト認識ルーティングなどの新しい高度な推論技術が必要です」「Together AIは、独自の推論エンジンを使用して業界をリードするパフォーマンスを提供します。NVIDIA Dynamoのオープン性とモジュール性により、そのコンポーネントをエンジンにシームレスに接続して、リソース使用率を最適化しながら、より多くのリクエストに対応できるようになり、加速コンピューティングへの投資を最大限に活用できます。NVIDIA Dynamoの画期的な機能を活用することで、オープンソースの推論モデルをコスト効率よくユーザーに提供できることを嬉しく思います」と語りました。

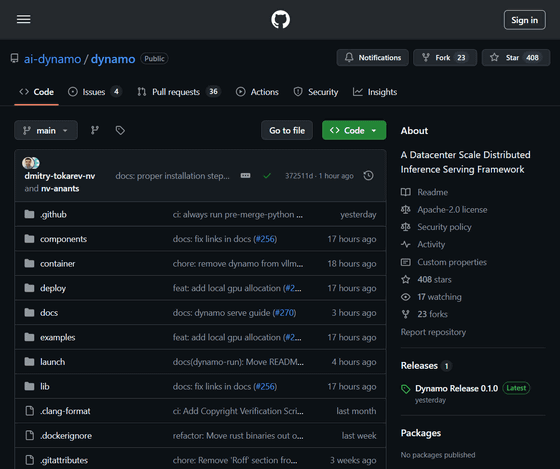

NVIDIA Dynamoはオープンソースで開発されており、PyTorch、SGLang、NVIDIA TensorRT-LLM、vLLMをサポートしているため、企業、スタートアップ、研究者は分散推論全体で AIモデルを提供する方法を開発および最適化できます。なお、ソースコードはGitHubで公開されています。

GitHub - ai-dynamo/dynamo: A Datacenter Scale Distributed Inference Serving Framework

https://github.com/ai-dynamo/dynamo

・関連記事

OpenAIが複雑な推論能力をもつAIモデル「OpenAI o1」と「OpenAI o1-mini」を発表、プログラミングや数学で高い能力を発揮 - GIGAZINE

OpenAI o1相当の推論モデル「DeepSeek R1」を中国AI企業が商用利用や改変が可能なMITライセンスでリリース - GIGAZINE

DeepSeekの推論モデル「DeepSeek-R1」をOpenAIのo1&o3と比較することで明らかになったこととは? - GIGAZINE

DeepSeekはどのようにしてOpenAIの3%のコストでo1を超えたのか? - GIGAZINE

・関連コンテンツ

in ソフトウェア, Posted by logu_ii

You can read the machine translated English article NVIDIA releases 'NVIDIA Dynamo,' an acce….